2024-05-22

Innovation Highlights

1. 团队构建了首个大规模双手协作双物体的数据集TACO,涵盖了大量日常生活中双手使用工具进行多物体协作的场景,通过提供丰富的交互三元组数据(工具、动作、使用对象),为通用手物交互的理解与生成带来了新的机遇与挑战。

2. 团队提出了一种结合数据和物理先验的手物交互去噪方法,通过引入刻画抓握可信度和操控可行性的神经损失函数,增强了手物交互的物理合理性,为高质量手物交互数据采集与生成提供了强有力的支持。

3. 团队印证了手物交互对于具身智能的重要价值并推出了GenH2R框架帮助机器人掌握通用的人机交接技能。该框架利用手物交互生成算法模拟人类行为,结合自动化示例生成和大规模模仿学习,在仅使用大规模合成数据进行训练的情况下,极大提升了真实世界中机器人与人类交接物体的成功率。

Achievements Summary

1. 创建首个大规模双手协作双物体的数据集—TACO

手物交互动作的理解与生成是虚拟/增强现实、机器人灵巧手操作和人机协作等领域的一个重要的基础课题。先前的技术方法大多关注单一物体的抓取和操作,而忽视了日常生活中更为常见的多物体协作,这归咎于相关的数据集和基准任务的不足。为了支持研究手物交互场景中不同物体的协作,弋力团队构建了首个大规模的双手使用工具实现双物体协作的四维数据集—TACO。TACO数据集的创建和相应的基准测试任务的提出,为计算机视觉领域中的手部-物体交互理解与合成的研究提供了新的视角和挑战,推动了该领域向更高层次的泛化性和智能化发展。

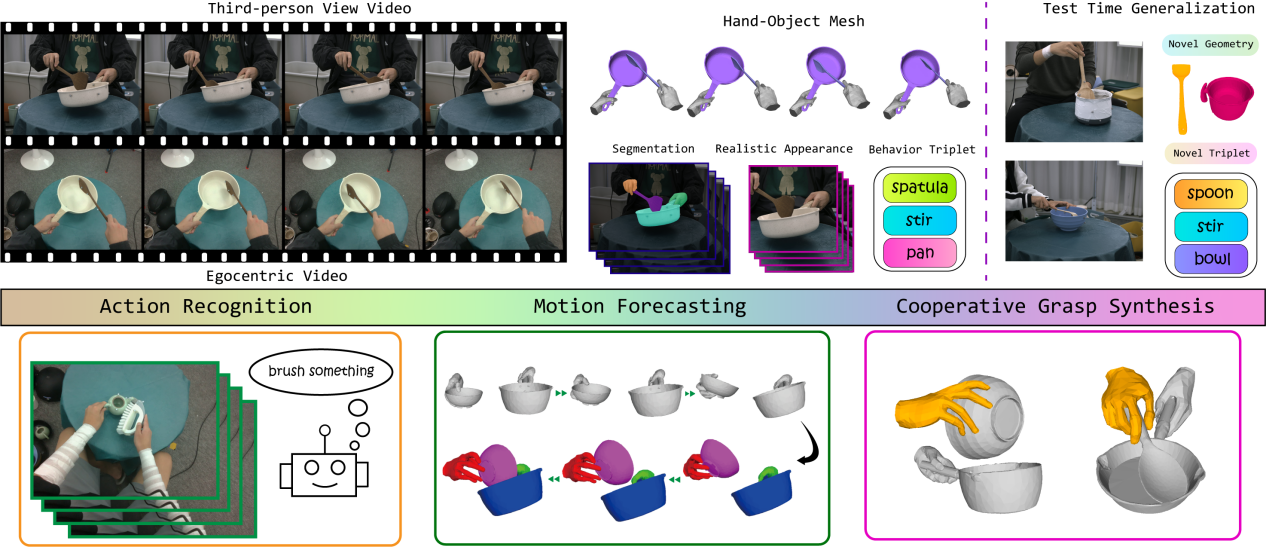

图1. TACO数据集

1)TACO数据集涵盖了日常生活中人们用双手使用工具完成任务的动作,将手物交互行为刻画成<工具-动作-使用对象>的交互三元组。提供了丰富的工具使用和物体操作的多样性,支持在测试时对未见物体几何形状和新的行为三元组进行泛化。涵盖了5.2M张来自第一和第三人称视角的彩色图片、2.5K段交互动作、131种“工具-动作-使用对象”的组合和196种物体形状。TACO关注数据内容包含第一和第三人称视角下的彩色视频、手和物体的三维网格序列、手和物体的二维掩码以及去除标志点的图片。

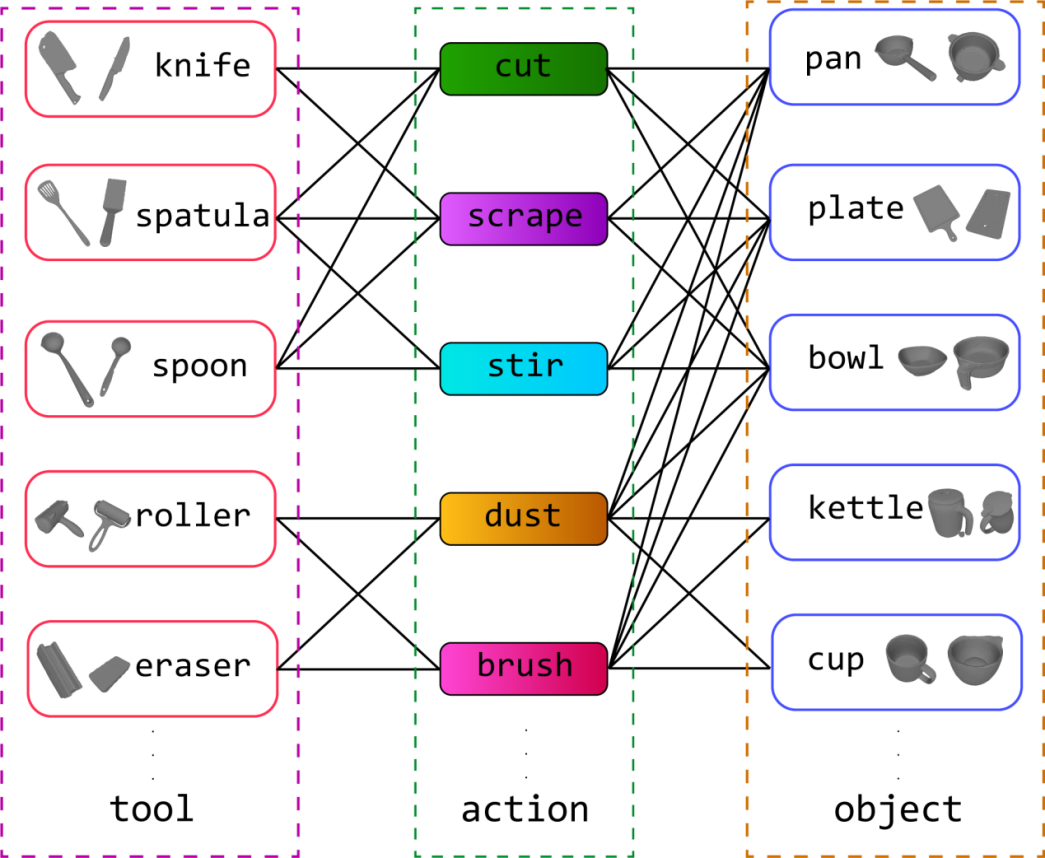

图2. TACO数据集中的交互三元组示例

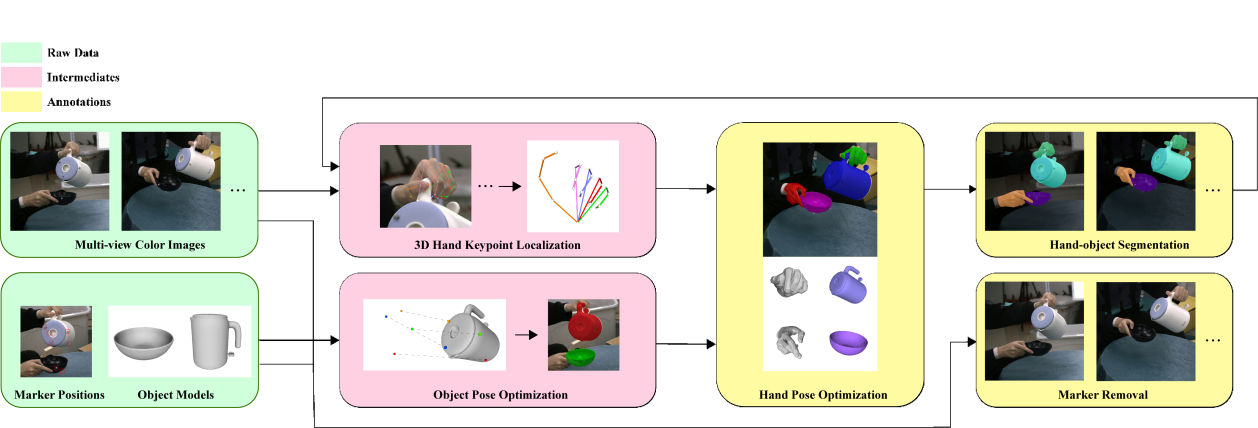

2)为了快速扩大数据规模,该工作贡献了一种基于彩色视频和光学动捕系统的全自动数据标注算法。这一流程能够同时保证运动质量和视觉数据质量,并为每个时间步自动提供标签,包括在无标记视觉数据上的精确手部-物体网格恢复和分割。

图3. 自动数据标注流程

3)在TACO数据集开拓的广阔研究空间中,团队提出了三个研究双物体协同操作的基准任务:动作识别、动作预测和合作式抓取生成,并关注现有的技术方法在物体形状和交互三元组等方面的泛化能力。三个基准任务中的大量实验表明现有方法在跨三元组的动作理解和在新物体、新类别上的抓取生成等方面尚存较大的提升空间,这为今后的研究带来了新的挑战和机遇。

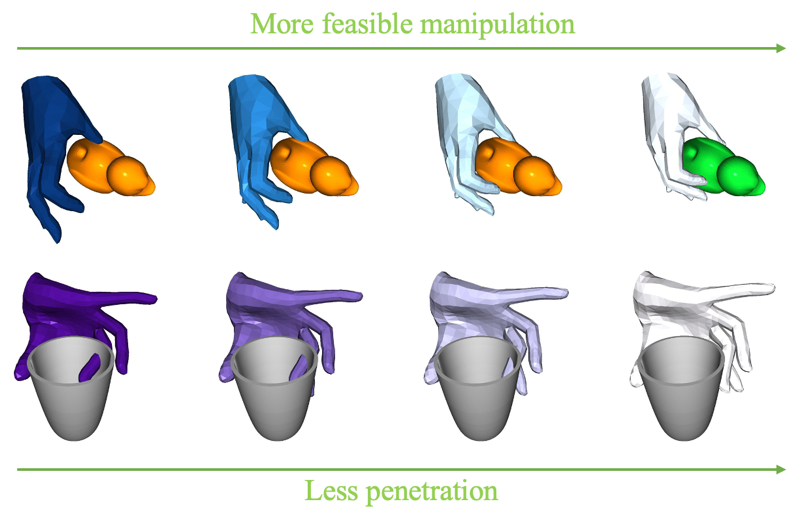

2. 关注物理合理性的手物交互去噪

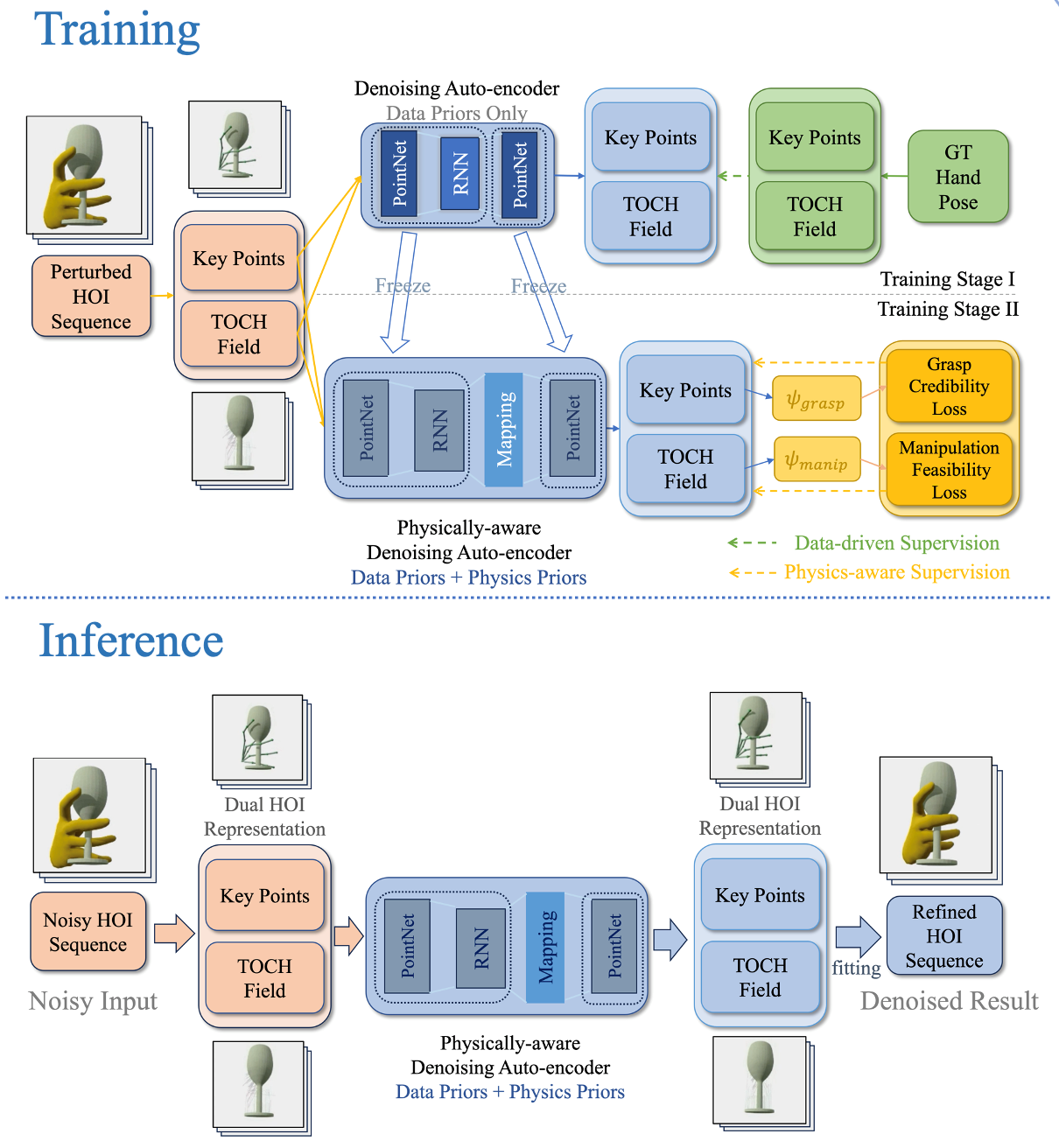

捕捉与物体交互的手是一个重要的研究问题,但由于手物遮挡、手的自遮挡、手本身具有自相似结构等缘故,只使用视觉输入来准确捕捉交互中的手的位姿是很困难的,这样得到的手物交互序列中往往含有大量噪声。弋力团队提出一套融合了数据驱动和物理先验知识的框架来为手物交互序列去噪,来增强手-物体交互的物理合理性。

图4. 训练和推理框架

1)该方法引入了两个刻画抓握可信度和操控可行性的神经损失函数来训练去噪网络,从而使其具有更好的物理感知能力。实验显示该方法在物理合理性和姿态准确性上都取得了提升。

2)物理合理性对于下游应用至关重要,但已有的去噪方法大多是纯数据驱动的,没有利用物理先验知识,手物交互过程中的物理合理性(即手物之间不发生穿模、手能够和物体发生合理的接触来驱动物体的运动等)难以得到有效保障。

3)建模抓取可信度和操纵可行性作为物理合理性的评价指标,又针对这两个方面引入了可微的神经损失函数,从而将其作为监督信号用来提升去噪网络进行物理推理的能力,最终得到物理合理性更好的去噪结果。

4)该框架既能提高物理合理性评价指标上的表现,也提高了传统的手物交互重建准确度评价指标上的表现。此外,对于不同的物体、运动模式和噪声模式,该框架有较好的泛化能力。

相关研究成果解决了手部跟踪中的物理合理性问题、数据驱动方法的局限性、物理意识网络的训练难题等,显著提高了手部姿势估计的准确性和物理合理性,为手-物交互跟踪领域提供了一种有效的解决方案。

图5. 示例—提出的神经损失

随着手部姿态的噪声水平降低而逐渐减少

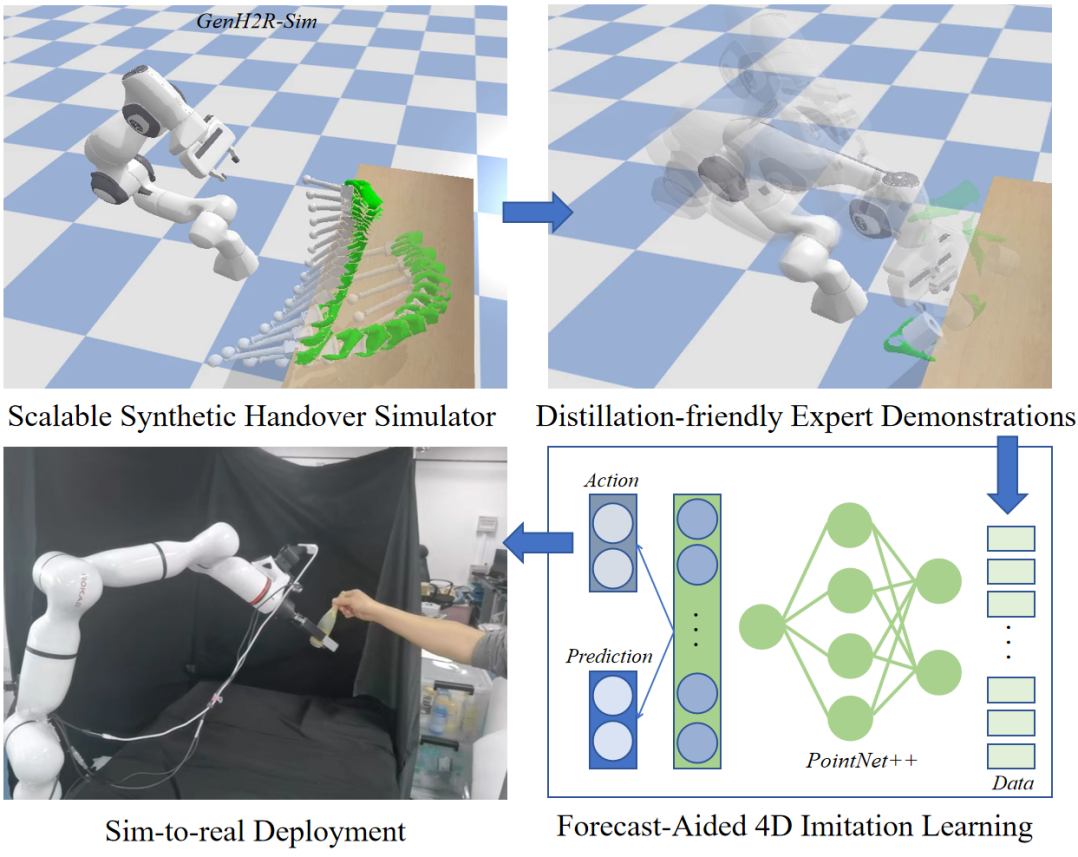

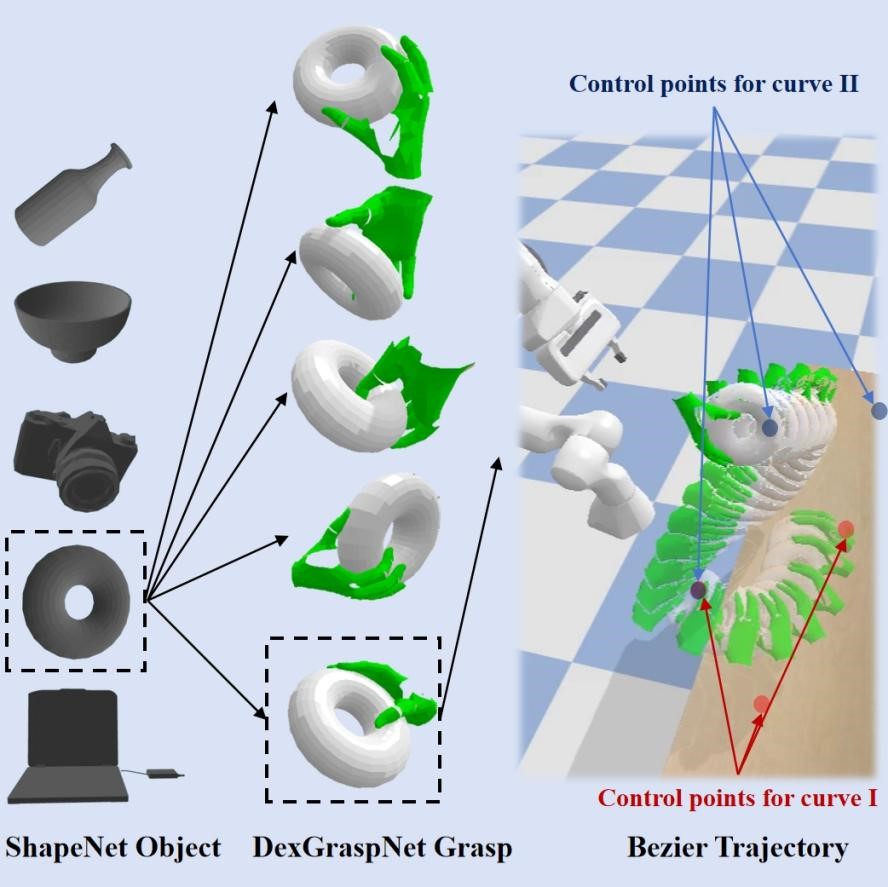

3. GenH2R—从可扩展的仿真、示例、模仿中学习通用人机交接

如何生成大量多样化的交接场景?如何创建高质量的演示以供学习?如何设计模仿学习算法以提高策略的泛化性和实时交互性?如何有效地将模拟中学习到的技能转移到现实世界中的机器人系统……针对Human-to-Robot (H2R)交接任务中一系列重要难题,弋力团队提供了一个更可靠、更通用的解决方案—GenH2R框架。

它能帮助机器人学习通用的与人交接物体的技能,面对任何物体、任何人类抓取方式与交接运动方式,都能够可靠完成交接任务,实现可泛化的人机交互。该方案不需要依赖任何真实示例数据,完全借助大规模合成数据赋能机器人。GenH2R框架别从仿真Simulation,示例Demonstration,模仿Imitation三个角度出发,让机器人第一次基于端到端的方式学习对任意抓取方式、任意交接轨迹、任意物体几何的通用交接。

图6. GenH2R 框架

1)在GenH2R-Sim环境中提供了百万级别的易于生成的各种复杂仿真交接场景,从抓取姿势和运动轨迹两方面对场景建模。

图7. 仿真环境GenH2R-Sim

2)引入一套自动化的基于视觉-动作协同的专家示例(Expert Demonstrations)生成流程,确保“专家”提供的示例具有视觉-动作相关性(Vision-action correlation)。

图8. 基于视觉-动作协同的专家示例

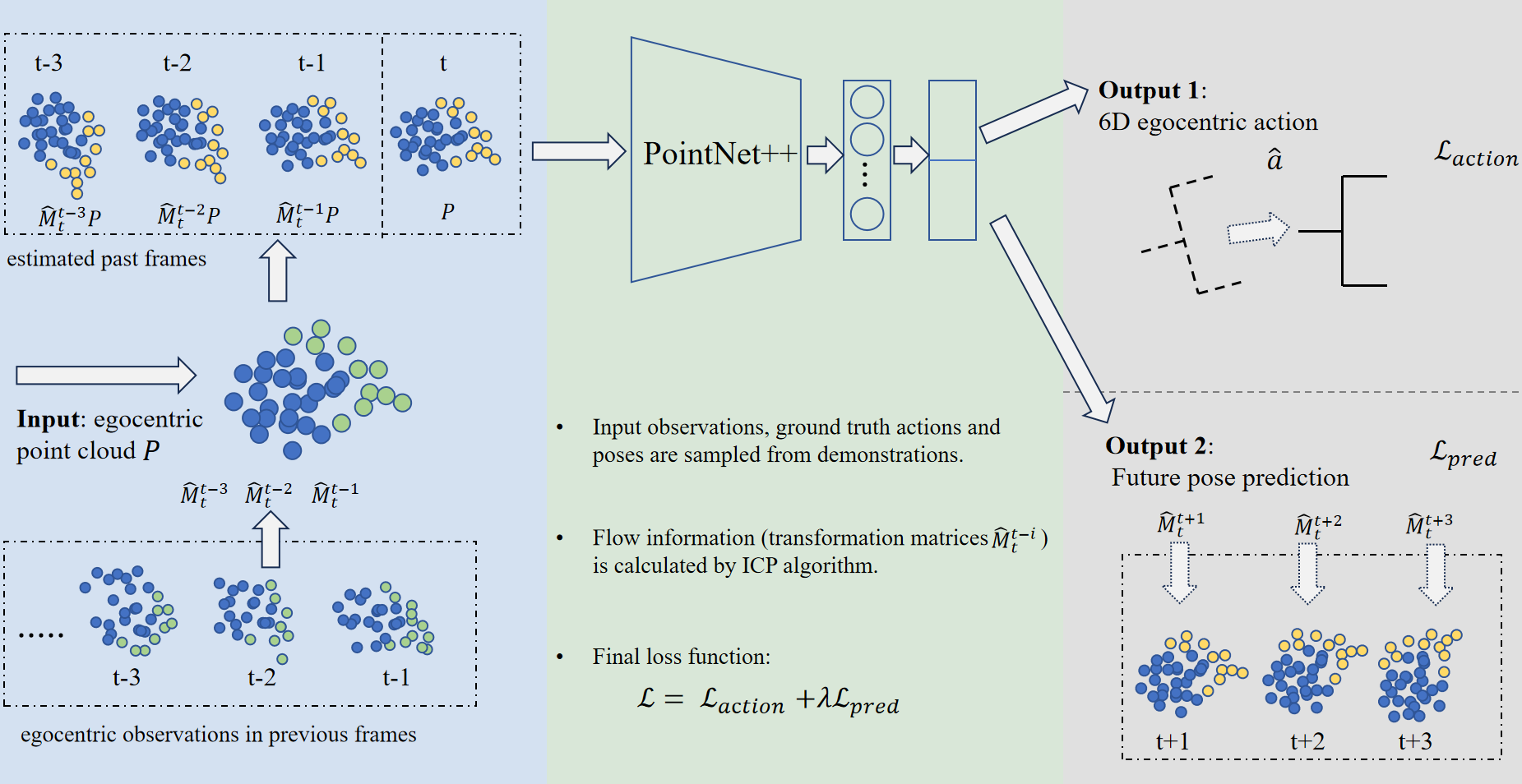

3)使用基于4D信息和预测辅助(点云+时间)的模仿学习(Imitation Learning)方法,模型架构的推理速度很快,更适用于交接物体这种需要低延时的人机交互场景。相比于SOTA方法(CVPR2023 Highlight)GenH2R的方法在各种测试集上平均成功率提升14%,并在真机实验中取得更加鲁棒的效果。

图9. 4D模仿学习方法

通过多样化的虚拟人递物行为仿真、自动化机器人示例生成、大规模4D模仿学习,此方案极大突破了现有方法的性能上限与泛化性,在各种测试集上的成功率都有至少10%的提升。

更多信息请阅读论文:

1. TACO: Benchmarking Generalizable Bimanual Tool-ACtion-Object Understanding, Yun Liu, Haolin Yang, Xu Si, Ling Liu, Zipeng Li, Yuxiang Zhang, Yebin Liu, Li Yi, https://arxiv.org/pdf/2401.08399, CVPR 2024.

2. Physic-aware Hand-Object Interaction Denoising, Haowen Luo, Yunze Liu, Li Yi, https://arxiv.org/pdf/2405.11481, CVPR 2024.

3. GenH2R: Learning Generalizable Human-to-Robot Handover via Scalable Simulation, Demonstration, and Imitation,Zifan Wang*, Junyu Chen*, Ziqing Chen, Pengwei Xie, Rui Chen, Li Yi†,https://GenH2R.github.io, CVPR 2024.

4. GenN2N: Generative NeRF2NeRF Translation, Xiangyue Liu, Han Xue, Kunming Luo, Ping Tan, Li Yi, https://xiangyueliu.github.io/GenN2N/, CVPR 2024.

分享到