2024-06-21

随着人工智能对算力及能源的巨大需求,以类脑算法(如脉冲神经网络)与模拟计算(新工艺存内计算)为代表的神经形态计算范式成为一大研究热点。上海期智研究院PI、上海交通大学副教授蒋力团队通过创新算法和硬件架构设计,为神经形态计算的高效性、安全性和实时性等亟待解决的关键难题提供新思路,进一步打开了边缘计算广阔应用场景。相关3项成果相继发表于体系结构、设计自动化领域的高水平国际会议DAC 2024、DATE 2024。

Innovation Highlights

量化作为DNN加速的常用手段,在实际使用过程中往往需要为异常值 (outliers) 付出较大的硬件和性能代价,本文提出一种算法/架构协同设计方案INSPIRE,通过引入索引对 (Index-Pair, INP) 量化有效解决上述问题,不仅低硬件开销低,软件使用友好,而且带来极高的性能增益。在自动驾驶、实时翻译、嵌入式系统等低功耗AI推理领域有较高技术价值。

Achievements Summary

基于索引对编码的DNN加速方案—INSPIRE

DNN推理消耗了大量的计算和存储资源。传统的量化方法大多依赖于固定长度的数据格式,在处理异常值 (outliers) 时往往导致模型精度下降。现有的可变长度量化方法涉及复杂的编码和解码算法,引入了显著的硬件开销。为解决这一问题,蒋力团队提出了一种针对DNN加速的算法/架构协同设计方案,引入索引对 (Index-Pair, INP) 量化方法,以低硬件开销和高性能增益有效处理了量化过程中的异常值,加速器有较好的软件亲和性。

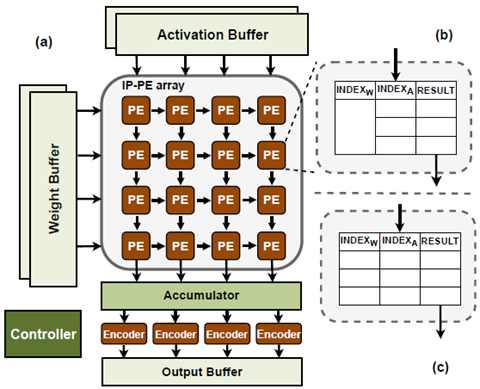

图1. INSPIRE架构概述

如图1所示,INSPIRE方案的核心在于:

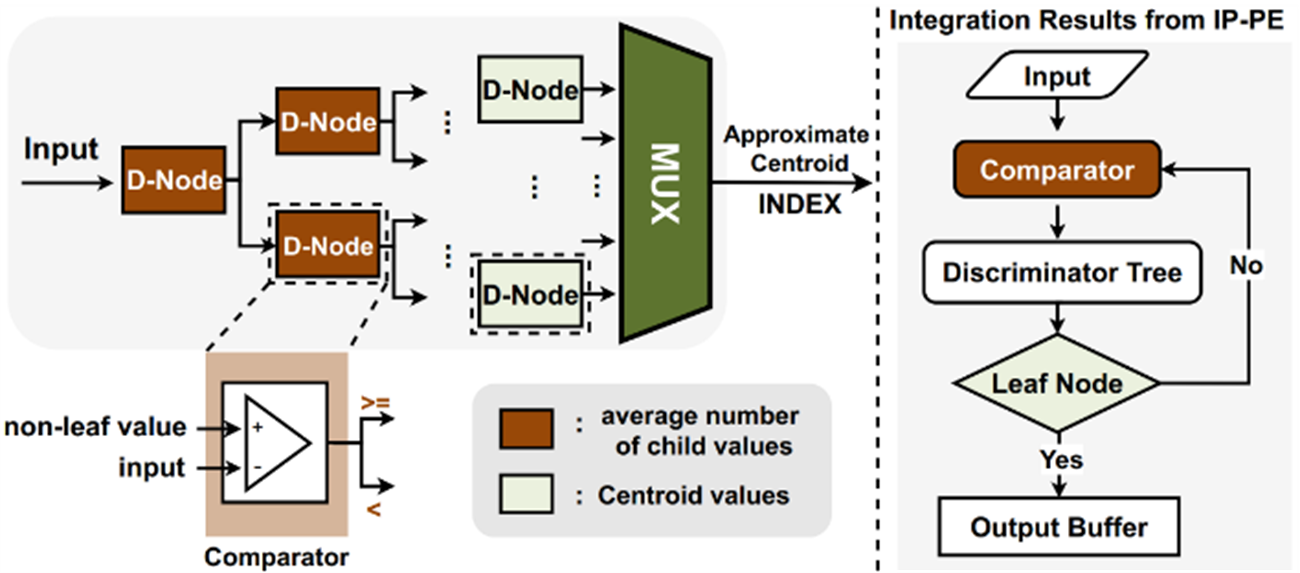

(1) 索引对量化 (INP Quantization) :使用可变长度量化,识别与重要值相关的数据特征并将其编码为索引。在推理过程中,利用查找表 (LUT) 高效地存储/检索预先(线下)计算的结果,从而消除了运行时的计算开销。

(2) 全局异常值处理:INSPIRE用聚类法确定激活值和权重的质心 (centroids),并对这些质心进行编码,有效地适应了不同值的重要性变化。主要聚类算法不仅作用于权重还作用域激活值,可以对两者同时量化索引。同时,有足够的索引空间来覆盖所有异常值。

(3) 统一处理单元架构 (Unified Processing Element Architecture):设计了一个统一的处理单元架构 (IP-PE),用基于索引对匹配的LUT单元,直接替换传统基于数值乘累加 (MAC) 操作的ALU单元,与可以现有DNN加速器架构无缝集成。实验结果表明,本方案的加速器在模型精度近乎无损的同时,性能加速9.31倍,能耗减少81.3%。

图2. INSPIRE编码器的设计及编码计算过程

INSPIRE创新了量化技术和架构设计,实现一种全新的DNN加速器设计,将在自动驾驶、实时翻译、嵌入式系统等领域具有广泛的应用前景。相关成果收录于DAC 2024中。本论文一作为期智研究院兼职研究员、上海交通大学助理研究员刘方鑫。

更多信息请阅读论文:

INSPIRE: Accelerating Deep Neural Networks via Hardware-friendly Index-Pair Encoding, Fangxin Liu, Ning Yang, Zhiyan Song, Zongwu Wang, Haomin Li, Shiyuan Huang, Zhuoran Song, Songwen Pei and Li Jiang, DAC 2024.

分享到