2024-05-09

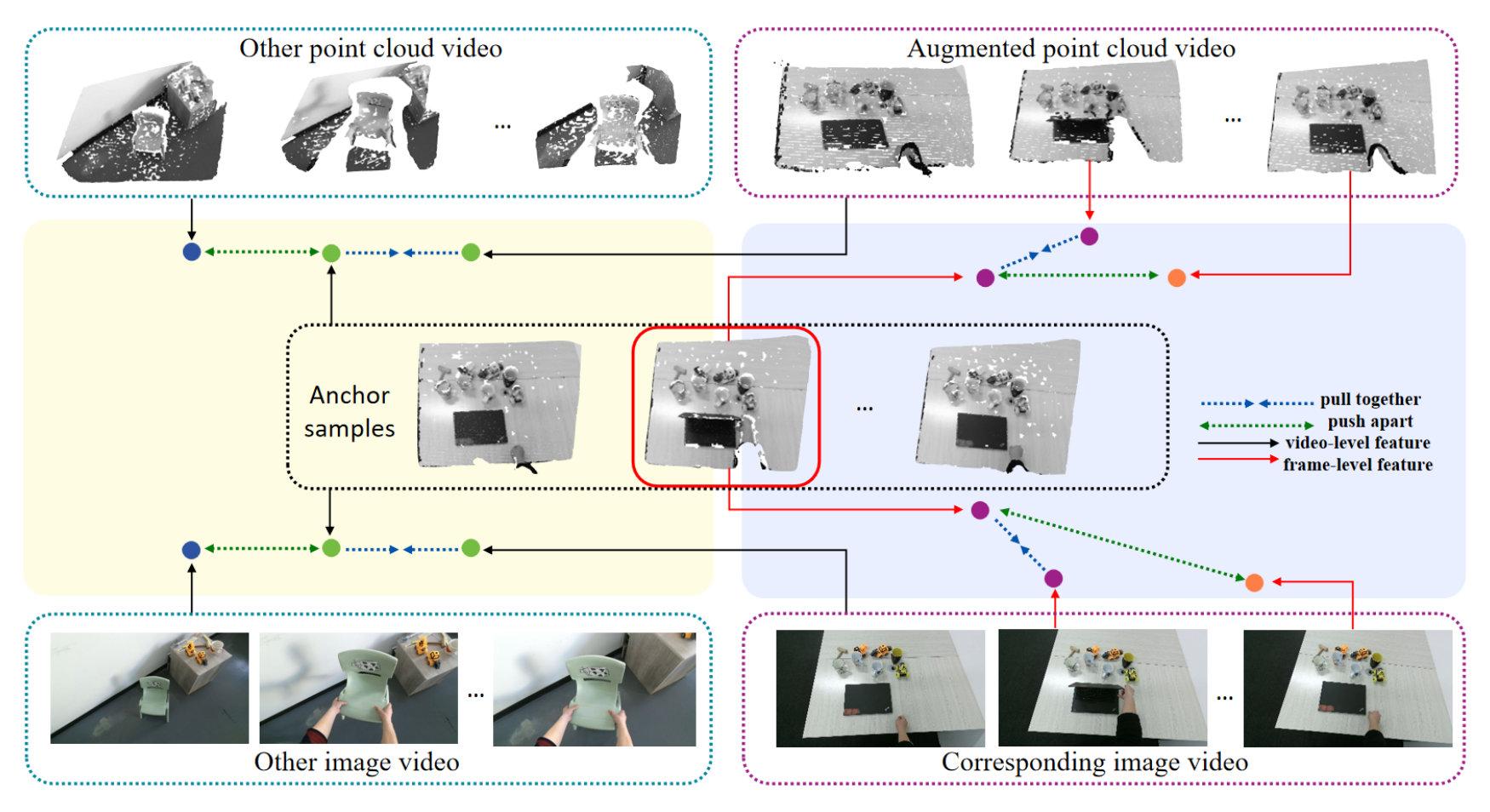

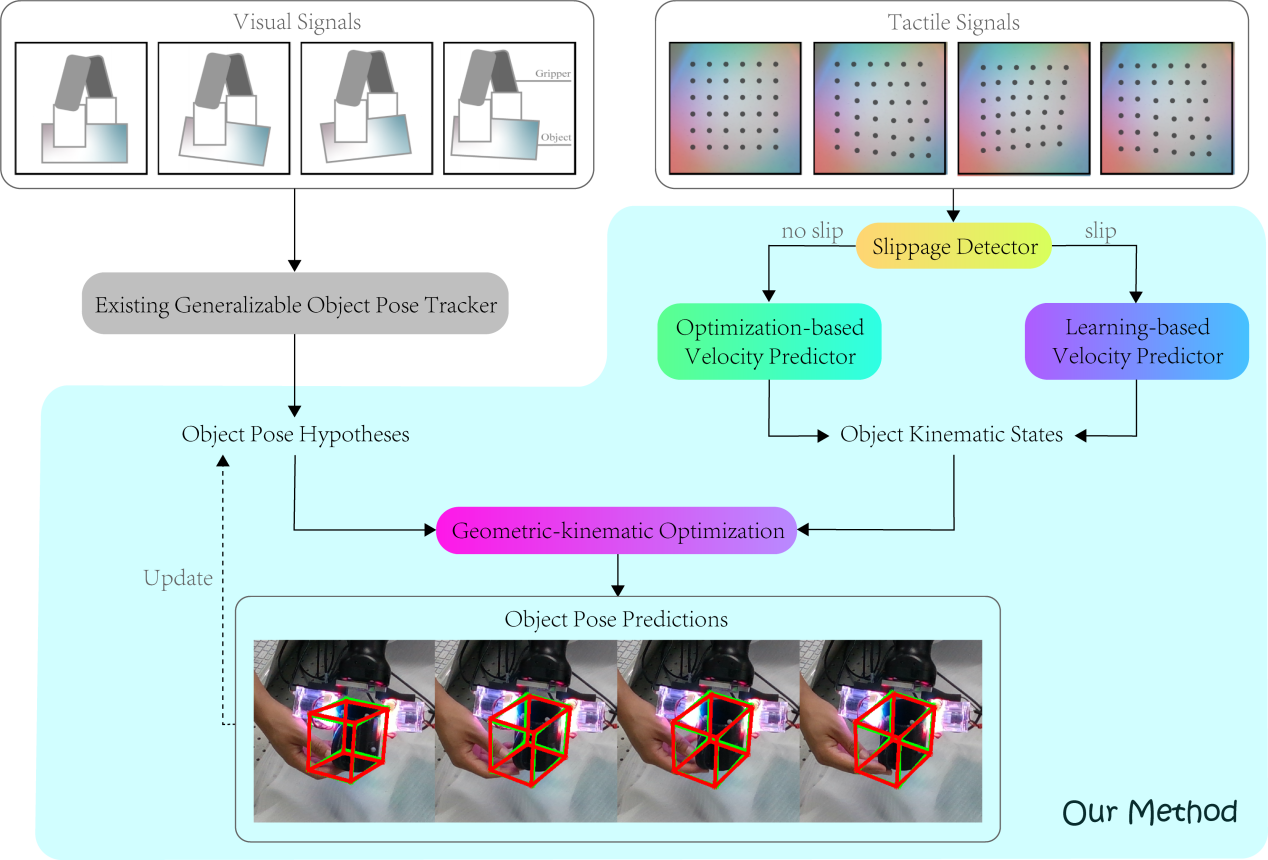

弋力团队在机器人视觉与触觉感知领域研究中取得重要进展,通过自监督学习和多模态数据融合来提升机器人对环境的理解和交互能力,在ICRA 2024上发表2项成果。提出了一种自监督的跨模态对比学习方法CrossVideo,通过模态内和跨模态的对比学习技术,提高点云视频理解的性能。团队提出了一种触觉增强的6D姿态跟踪系统TEG-Track,用于跟踪手中持有的未见过的物体。该方法在合成和真实世界场景中均能一致性地提升最先进的通用6D姿态跟踪器的性能。相关成果可运用推广到机器人导航、增强现实、自动化驾驶等领域。

论文题目:CrossVideo: Self-supervised Cross-modal Contrastive Learning for Point Cloud Video Understanding

论文作者:Yunze Liu, Changxi Chen, Zifan Wang, Li Yi

论文链接:https://arxiv.org/abs/2401.09057

论文题目:CrossVideo: Self-supervised Cross-modal Contrastive Learning for Point Cloud Video Understanding

论文作者:Yun Liu*, Xiaomeng Xu*, Weihang Chen, Haocheng Yuan, He Wang, Jing Xu, Rui Chen, Li Yi

数据集和代码:https://github.com/leolyliu/TEG-Track

论文链接:https://ieeexplore.ieee.org/abstract/document/10333330